Les Etats cherchent à lutter contre les trucages numériques hyperréalistes, vecteurs de désinformation

Publié le - par Le blob.fr, avec l'AFP

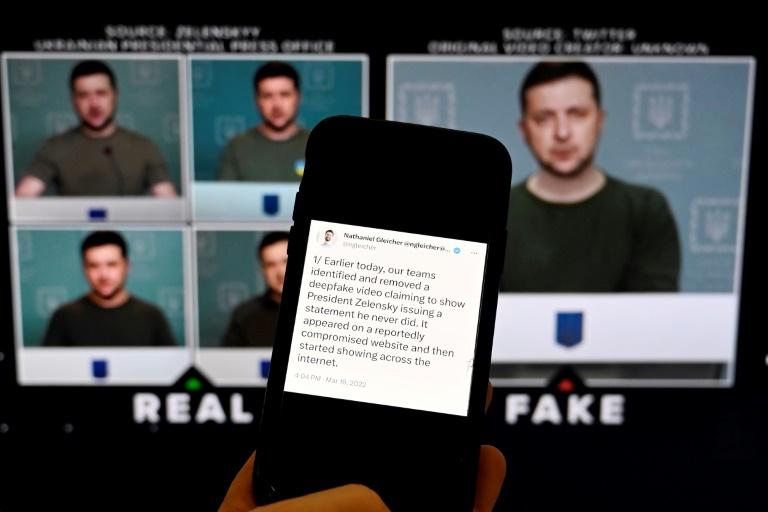

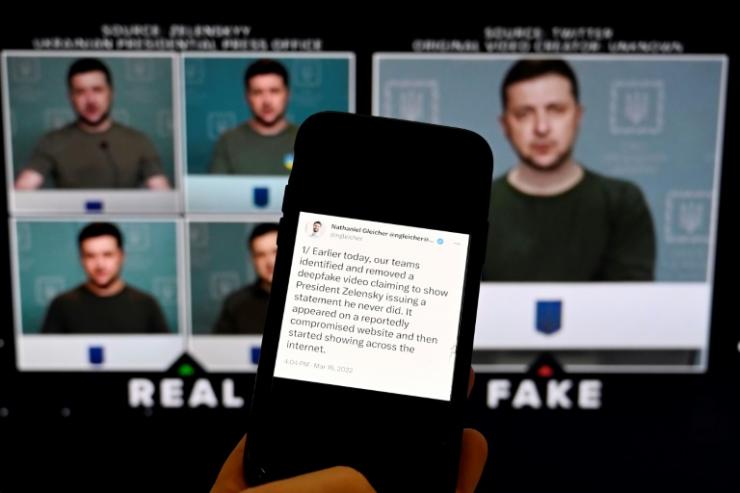

Robots conversationnels propageant des fausses informations, applications générant des vidéos pornographiques trafiquées, voix clonées utilisées pour des fraudes : face à la montée en puissance des technologies d'hypertrucage, les gouvernements commencent à organiser la riposte. La prolifération des « deepfakes », ces manipulations numériques qui permettent grâce à l'intelligence artificielle de remplacer dans une vidéo un visage par un autre ou de falsifier les propos d'une personnalité avec un réalisme déconcertant, présentent désormais un défi majeur en matière de désinformation. Meta, qui possède Facebook, avait par exemple annoncé l'année dernière avoir retiré une vidéo « deepfake » du président ukrainien Volodymyr Zelensky appelant les citoyens à baisser les armes et à se rendre aux troupes russes.

Kate Isaacs, une Britannique qui milite pour que les contenus pornographiques réalisés sans consentement soient retirés du site Pornhub, a raconté en octobre dernier à la BBC s'être « effondrée » quand une vidéo porno « deepfake » avec son visage a été publiée sur Twitter. Les outils de détection de ce type de contenus sont dépassés par leurs créateurs, mettent en garde les experts du secteur. Ils opèrent en effet de façon anonyme grâce à des techniques d'intelligence artificielle qui nécessitaient auparavant des compétences spécialisées mais sont désormais accessibles au grand nombre et à bas coût.

« Armes de perturbation massive »

Cette démocratisation de la création automatisée de contenus texte, audio et vidéo, et son utilisation potentiellement malveillante, à des fins de fraude financière ou d'usurpation d'identité, ont suscité de fortes inquiétudes à travers le monde. Ces technologies ont notamment été qualifiées « d'armes de perturbation massive » par le cabinet d'analyse des risques Eurasia Group. La start-up britannique ElevenLabs, qui développe un outil de clonage de voix grâce à l'intelligence artificielle, a admis cette semaine constater un « nombre croissant d'utilisation abusive » de son logiciel. Des utilisateurs avaient posté un clip généré avec cet outil où une imitation de la voix de l'actrice Emma Watson lisait un passage de Mein Kampf. L'essor de l'hypertrucage pourrait mener à ce que l'agence de police européenne Europol a décrit comme une « apocalypse de l'information », un scénario où de nombreuses personnes seraient incapables de distinguer la réalité de la fiction et de savoir quelles sont les sources d'information fiables.

Un avant-goût de ce phénomène a eu lieu le week-end dernier lorsque le joueur de football américain Damar Hamlin a remercié dans une vidéo à destination de ses fans l'équipe médicale qui l'a soigné après son arrêt cardiaque pendant un match. Beaucoup de conspirationnistes, persuadés que son malaise sur le terrain était en réalité dû au vaccin contre le Covid-19, ont alors crié au « deepfake ».

« Super-propagateur »

La Chine, à la pointe en matière de réglementation des nouvelles technologies, a annoncé début janvier l'entrée en vigueur d'une nouvelle réglementation encadrant l'hypertrucage, qui impose désormais aux entreprises chinoises offrant ce genre d'outils d'obtenir l'identité réelle de leurs utilisateurs. Le texte rend par ailleurs obligatoire l'apposition d'une mention sur les « deepfakes », afin d'éviter « toute confusion » pour le public.

L'hypertrucage présente un « danger pour la sécurité nationale et la stabilité sociale » s'il n'est pas encadré, avait ainsi estimé le mois dernier le gendarme chinois de l'internet. Aux Etats-Unis, des élus souhaitent la mise en place d'un groupe de travail spécialisé dans la surveillance des « deepfakes » mais sont confrontés à une levée de boucliers de militants des droits numériques. Ces derniers alertent sur les risques de telles mesures qui pourraient, selon eux, brider l'innovation ou réduire la liberté d'expression.

En Europe, le gouvernement britannique a déclaré en novembre qu'il allait rendre illégal le partage de vidéos pornographiques « deepfakes »réalisées sans le consentement des victimes. L'Union européenne planche de son côté sur un projet de loi, l’ « AI act », sur l'intelligence artificielle, censé encourager l'innovation et éviter les dérives, qu'elle envisage de passer avant la fin de l'année. Le texte imposerait notamment aux utilisateurs de mentionner qu'ils publient un « deepfake » mais certains craignent qu'il n'aille pas assez loin.

« Comment réinstaurer la confiance numérique avec transparence? C'est la vraie question », explique Jason Davis professeur à l'université de Syracuse. « Les outils (de détection) arrivent et plutôt rapidement. Mais la technologie avance sans doute encore plus vite. Comme la cybersécurité, nous ne résoudrons jamais ce problème, on peut seulement espérer garder la cadence », poursuit-il. Beaucoup ont déjà du mal à appréhender des nouveaux outils comme le robot conversationnel ChatGPT, créé par l'entreprise californienne OpenAI, qui peut générer des dissertations, articles ou poèmes, sur demande et en quelques secondes.

NewsGuard, qui évalue les sources d'information en fonction de leur fiabilité, l'a qualifié dans une récente étude de « nouveau super-propagateur de désinformation », car ChatGPT avait donné des réponses « fausses et trompeuses » à des questions sur le Covid-19 ou les fusillades scolaires.